Smart Connections刚装了一下,功能非常多,不过对于普通人来讲确实不太友好,很多地方的配置是需要专业知识的,要是能更傻瓜一点就好了

我也遇到过类似的问题,不知道是否和 RAG 本身有关。比如,假如我问一个笼统的问题,那么一般他无法给出让我满意的回答;假如我知道某个笔记中有我想要的答案,然后基于那个笔记的内容问一个非常具体的问题,那么,回答的效果会比笼统问题好很多。似乎 RAG 适合用于问答非常具体的问题,否则就像大海捞针那样,可能无法给出满意的回答。

目前对于 Smart Connections 的使用有类似的感觉。尝试按照官方文档设置,但还是放弃了。又是涉及 Smart Connect,又是涉及几个其他工具之类的。而且发现,针对我的一个小 Vault 嵌入时,花费的时间特别长,比 Copilot 长多了。

是这样的。RAG只是检索

我认为对于记笔记与写笔记这两件事来说,本质的过程是搜集、输入、整理、输出。

那么AI应该增强的功能是更快的输入、更快的整理。

比如当我们在阅读/刷到一些认为是有价值的信息,在进行搜集这一动作后。应该由AI来进行总结、并且打标。或者如果认为AI的能力不足,可以人工参与。比如AI先对新信息进行重复度以及内容质量这两个维度的打分。然后再由人工标注、总结,毕竟现在网络上充斥着大量低质的、垃圾的信息。而在这一步骤后,信息会变成碎片化的笔记。

再然后我们可以对这些碎片笔记进行整理,这一目的是为了一以贯之,在各种不同的学习法中都有类似的理念。那么AI可以帮助我们对不同笔记的关联度进行一个量化打分。也可以再对笔记进行提炼总结,辅助将这些笔记按照道、法、术进行分类。

换一个思路,现在msty支持直接对obsidian vault进行向量化,是否不用专门再找这种插件,避免各种配置升级麻烦了?

或者是为了写作,还是通过obsidian调用比较好,目前24年底哪个插件对需要向量化的小白最友好?

感谢推荐 Msty, 这个工具界面看着挺清爽的, 简单试了下

- 它是连到 本地文件 / 本地文件夹 / Ob Vault; 然后文本拆分到句子级, 去做 RAG

- “连接到 Ob 仓库” 而不要求用户把数据再重新上传一遍, 这么处理确实跟 Ob 挺搭的

- “配置模型参数” 和 “配置本地知识库” 的界面, 做的挺清晰的, 尽可能避免了把复杂参数直接扔用户一脸

- 但是嵌入时我遇到报错了

"msg":"Error embedding document chunk: {\"code\":\"ERR_INVALID_URL\",\"input\":\"http://127.0.0.1:undefined\"}"正琢磨咋解决

是否不用专门再找这种插件,避免各种配置升级麻烦了?

Ob 的优势在于文件 + markdown, 所以能跟绝大部分知识库工具合作, 我也赞同围绕 Ob 造知识库不一定靠 Ob 插件

但是另一方面, 个人观点目前所有这些工具, 其实选啥都免不了折腾啊

且国内用户还面临额外困难: 找第三方的兼容 OpenAI API, 找适合中文的 Embedding, 分割 chunk 时需要认中文标点, 需要按照汉字估计 token, …

或者是为了写作,还是通过obsidian调用比较好

个人觉得, 得看 “边查边写” 的比例

其实大部分情况下, 我自己可能更希望 “RAG 查资料” 要快 稳定 能溯源

而对于 “把生成文本直接给放笔记正文的自动化过程”, 这没有也能忍, 忍不了再去优化

当然, 利用 Ob 内插件能做到 glowingjade/obsidian-smart-composer 这种效果, 对于需要大量修改编辑的场景, 是挺有价值的

目前24年底哪个插件对需要向量化的小白最友好?

Smart Connections 和 Copilot 都在频繁更新, 都比之前好用了许多

似乎 Copilot 的社区讨论和资料更多些, 很少见人讨论 Smart Connections

另一个比较省心的, 大概是 Obsidian + Cursor 最近已经许多人推荐过了,

好处: 连嵌入模型都不用配, Cursor 直接给包办了

缺点: 对于非技术用户, 操作方式有点陌生, 比如 @Codebase 这种交互就很怪

我试了一下,不得不承认小白还是很难搞定配置,msty缺省是gemma,下了ollama但是不知道怎么在copilot中配置,smart connection更不用说了,有谁知道哪里有合适的教程吗?

因为用了第三方工具装本地ai,网上的教程不太适用

之前没主意到推荐的这个smart composer,(插件名字拼错了)

挺好用,一下子msty就配好了,能自动探测安装的模型

但是,即使有本地markdown笔记rag,本地AI真蠢。。。。一本正经胡说八道

下了ollama但是不知道怎么在copilot中配置

可以参考 Copilot 的文档 obsidian-copilot/local_copilot.md 以及这篇 本地大语言模型接入obsidian,打造专属第二大脑! - 知识管理工具

其实没有隐私问题且没有联网问题时, 个人建议用在线模型:

- 本地模型: 自己捣鼓下载安装, 自己启动服务, 不用时开着占资源, 关了下次用时再开也麻烦

- 在线模型: 响应快, 不占自己资源, 反正服务端出事了全赖对方, 我只管好本地正确调用了就行

即使有本地markdown笔记rag,本地AI 一本正经胡说八道

这问题就复杂了… 这一大堆零件组成的系统, 哪里出事都可能导致效果不好

如果能看到 prompt 里拼凑到了靠谱的文本片段, 但 AI 回复的质量不好, 那确实得换模型了

学到了,留名期待后期的更新,期待那种有ai整理笔记的插件,把不重要的笔记直接让ai整理,最好这个ai可以整理出原版本与改写总结后的差异对比之类的,方便知道大概哪些地方进行了改动 ![]()

smart composer功能相当丰富很像cursor有差异对比,管理文件现在这有点难

可以用openrouter国内外模型都有,deepseek,qwen免费版也特别好用

请问现在想要在obsidian中配合使用大语言模型推荐哪个

大佬好,我现在在弄copilot插件的deepseek模型,目前在embed模型选择上出现了问题。当我按照哔站视频采用硅基流动的API时,可以实现copolot的对话模型和embed模型,会出现相关文章推荐,但是用deepseek官网的API就没法实现embed模型,这个请问有没有适配deepseek官方API的embed模型?

请问现在想要在obsidian中配合使用大语言模型推荐哪个

个人建议在能力合格之后, 找速度快+便宜的模型

- 能力合格: 如果是 Ob 里 总结 / 改写 / RAG回答简单问题 等等, 其实不需要特别强的模型, 大致够用就行

- 例: deepseek-v3 就行了, 不必非得 r1, 其它的 Qwen Kimi 等等都可以

- 能力出色: 但若需大量的风格文字创作 / 解难题, 这类任务, 那可能得顶尖水平模型, 看自己实际需求

- 速度快+便宜: 响应太慢用着憋屈啊

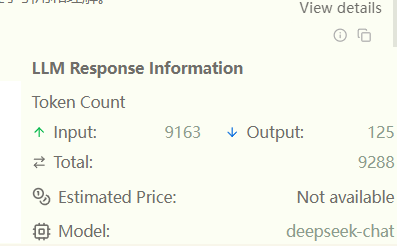

如果大量使用 RAG 对仓库提问, 且分块设置较大, 例如设置 chunk-size=1000 设置召回 10个片段, 那模型支持的输入 token 得长一点, 上例拼凑这些片段到提示词里, 估计要 5000~10000 tokens

有些工具能统计输入 token 数量 (不能统计也没事, 心里大致估计一下就完了)

采用硅基流动的API时,可以实现copolot的对话模型和embed模型,会出现相关文章推荐,但是用deepseek官网的API就没法实现embed模型

这个没看懂, 目前 deekseek 没 embedding 模型, 把 deekseek API 填到 嵌入 那一栏, 也没啥用

用硅基的话, 嵌入模型就 BAAI/bge-m3 / Pro/BAAI/bge-m3 呗

Copilot 好处是可以填 “第三方的在线嵌入模型”

请问有没有适配deepseek官方API的embed模型?

聊天模型和嵌入模型这俩是相互不干扰的,

嵌入模型尽量不要换, 若换, 需要全库重做嵌入

聊天模型可以中途任意更换

谢谢大佬回复,请问现在obsidian的ai插件哪个好用?目前发现都各有优劣,有些功能还会重叠,就感觉怪怪的

我自己最常用的是 local gpt,小众但是好用,自定义足够

chat类我觉得copilot雷声大雨点小 很热门不好用,开发者倾向搞钱(无贬义,只是取舍不同)

可以参考我这篇文章,没有收录tars

现在看smart connection 还是很简陋,嵌入模型部分默认配置几乎不可用

聊天部分配置简陋,聊天窗口也简陋,配置api的部分和主流客户端不一样,还有一个低级错误(例如端口它写可以leave blank,但是实际上不填会报异常。